Meta Platforms представила Llama 4, новое семейство открытых моделей искусственного интеллекта, включающее Llama 4 Scout, Maverick и Behemoth. Ключевой особенностью моделей является поддержка мультимодального взаимодействия, позволяющая обрабатывать не только текстовые запросы, но и изображения, видео и другие типы данных. Для обеспечения широкого визуального понимания модели обучались на огромном объеме немаркированных текстовых, графических и видеоданных.

Успехи китайской компании DeepSeek, чьи ИИ-модели демонстрируют производительность на уровне или даже выше флагманских алгоритмов Llama предыдущих поколений, побудили Meta Platforms активизировать усилия по разработке новых ИИ-решений. По информации источника, Meta активно изучает опыт DeepSeek, чтобы понять, как компании удалось снизить затраты на разработку и развертывание таких моделей, как R1 и V3.

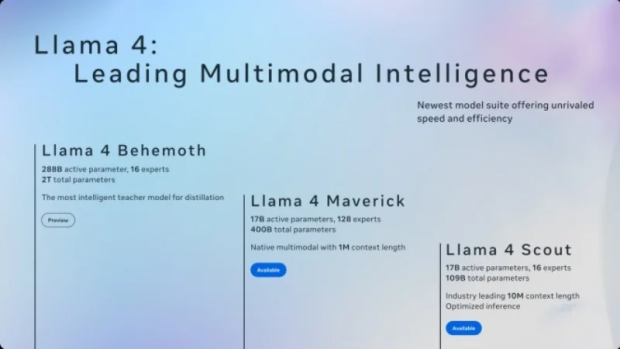

Meta Platforms представила подробные характеристики моделей семейства Llama 4. Алгоритм Llama 4 Scout имеет 17 млрд активных параметров, 16 «экспертов» и 109 млрд параметров в общей сложности, демонстрируя превосходство над Gemma 3, ChatGPT 2.0 Flash-Lite и Mistral 3.1 в различных задачах и поддерживая контекстное окно в 10 млн токенов.

Llama 4 Maverick, с 17 млрд активных параметров и 128 «экспертов» (400 млрд параметров всего), превосходит -4o и ChatGPT 2.0 Flash в бенчмарках и сопоставима с DeepSeek V3 в рассуждениях и написании кода. Для работы Scout достаточно одного Nvidia H100, тогда как Maverick требует Nvidia H100 DGX или аналогичную систему. Llama 4 Behemoth, самая мощная модель с 288 млрд активных параметров и 16 «экспертов» (около 2 трлн параметров), пока находится в стадии обучения и недоступна, но уже превосходит -4.5, Claude Sonnet 3.7 и ChatGPT 2.0 Pro в тестах. Scout и Maverick уже доступны на Llama.com и Hugging Face.

Meta также перевела своего ИИ-помощника Meta AI в WhatsApp, Messenger и Instagram на Llama 4 в 40 странах, однако мультимодальные запросы пока поддерживаются только на английском языке и в США.

Горячие темы